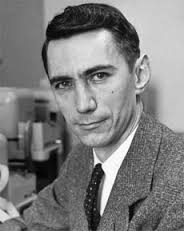

La ciencia busca las leyes básicas de la naturaleza. Las matemáticas buscan nuevos teoremas que se basen en los antiguos. La ingeniería construye sistemas para resolver las necesidades humanas. Las tres disciplinas son interdependientes pero distintas. Es muy raro que una persona haga simultáneamente contribuciones fundamentales a las tres, pero Claude Shannon era una persona rara.

A pesar de ser el protagonista del reciente documental The Bit Player -y de que su trabajo y filosofía de investigación han inspirado mi propia carrera- Shannon no es precisamente un nombre conocido. Nunca ganó un Premio Nobel y no era una celebridad como Albert Einstein o Richard Feynman, ni antes ni después de su muerte en 2001. Pero hace más de 70 años, en un único e innovador artículo, sentó las bases de toda la infraestructura de comunicación que subyace a la era moderna de la información.

Shannon nació en Gaylord, Michigan, en 1916, hijo de un empresario local y una profesora. Tras licenciarse en ingeniería eléctrica y matemáticas por la Universidad de Michigan, escribió una tesis de máster en el Instituto Tecnológico de Massachusetts que aplicaba una disciplina matemática llamada álgebra de Boole al análisis y la síntesis de circuitos de conmutación. Fue un trabajo transformador, que convirtió el diseño de circuitos de un arte a una ciencia, y ahora se considera que fue el punto de partida del diseño de circuitos digitales.

A continuación, Shannon puso la mira en un objetivo aún mayor: la comunicación.

Claude Shannon escribió una tesis de maestría que puso en marcha el diseño de circuitos digitales, y una década más tarde escribió su documento seminal sobre la teoría de la información, «Una teoría matemática de la comunicación».

La comunicación es una de las necesidades humanas más básicas. Desde las señales de humo hasta las palomas mensajeras, pasando por el teléfono y la televisión, el ser humano siempre ha buscado métodos que le permitieran comunicarse más lejos, más rápido y de forma más fiable. Pero la ingeniería de los sistemas de comunicación siempre estuvo ligada a la fuente y el medio físico específicos. Shannon, en cambio, se preguntó: «¿Existe una gran teoría unificada para la comunicación?». En una carta de 1939 a su mentor, Vannevar Bush, Shannon esbozó algunas de sus ideas iniciales sobre «las propiedades fundamentales de los sistemas generales para la transmisión de inteligencia». Tras trabajar en el problema durante una década, Shannon publicó finalmente su obra maestra en 1948: «Una teoría matemática de la comunicación».

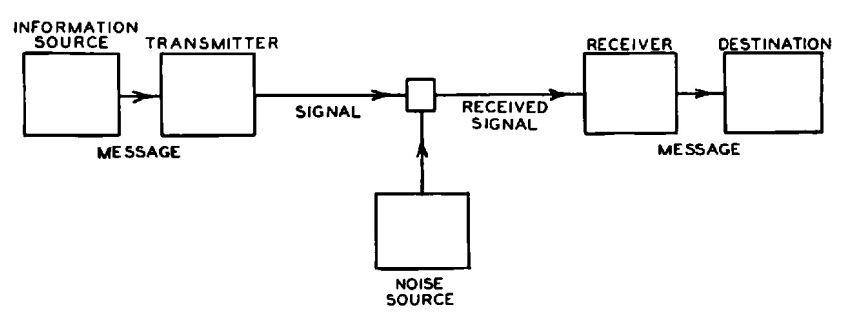

El núcleo de su teoría es un modelo sencillo pero muy general de comunicación: Un transmisor codifica la información en una señal, que es corrompida por el ruido y decodificada por el receptor. A pesar de su simplicidad, el modelo de Shannon incorpora dos ideas clave: aislar las fuentes de información y de ruido del sistema de comunicación que se va a diseñar, y modelar ambas fuentes de forma probabilística. Imaginó que la fuente de información generaba uno de los muchos mensajes posibles para comunicar, cada uno de los cuales tenía una determinada probabilidad. El ruido probabilístico añadía más aleatoriedad para que el receptor pudiera desentrañar.

Antes de Shannon, el problema de la comunicación se consideraba principalmente un problema de reconstrucción de señales deterministas: cómo transformar una señal recibida, distorsionada por el medio físico, para reconstruir el original con la mayor precisión posible. La genialidad de Shannon reside en su observación de que la clave de la comunicación es la incertidumbre. Al fin y al cabo, si supiera de antemano lo que le voy a decir en esta columna, ¿qué sentido tendría escribirla?

Diagrama esquemático del modelo de comunicación de Shannon, extraído de su documento.

Esta única observación desplazó el problema de la comunicación de lo físico a lo abstracto, permitiendo a Shannon modelar la incertidumbre utilizando la probabilidad. Esto supuso un shock total para los ingenieros de comunicación de la época.

En este marco de incertidumbre y probabilidad, Shannon se propuso determinar sistemáticamente el límite fundamental de la comunicación. Su respuesta se divide en tres partes. El concepto de «bit» de información, utilizado por Shannon como unidad básica de incertidumbre, desempeña un papel fundamental en las tres. Un bit, que es una abreviatura de «dígito binario», puede ser un 1 o un 0, y el documento de Shannon es el primero en utilizar la palabra (aunque él dijo que el matemático John Tukey la utilizó primero en un memorando).

En primer lugar, Shannon ideó una fórmula para el número mínimo de bits por segundo para representar la información, un número que denominó tasa de entropía, H. Este número cuantifica la incertidumbre que supone determinar qué mensaje generará la fuente. Cuanto menor sea la tasa de entropía, menor será la incertidumbre y, por tanto, más fácil será comprimir el mensaje en algo más corto. Por ejemplo, enviar mensajes de texto a un ritmo de 100 letras inglesas por minuto significa enviar uno de los 26100 mensajes posibles cada minuto, cada uno representado por una secuencia de 100 letras. Se podrían codificar todas estas posibilidades en 470 bits, ya que 2470 ≈ 26100. Si las secuencias fueran igualmente probables, la fórmula de Shannon diría que la tasa de entropía es efectivamente de 470 bits por minuto. En realidad, algunas secuencias son mucho más probables que otras, y la tasa de entropía es mucho menor, lo que permite una mayor compresión.

En segundo lugar, proporcionó una fórmula para el número máximo de bits por segundo que pueden comunicarse de forma fiable frente al ruido, que denominó capacidad del sistema, C. Se trata de la velocidad máxima a la que el receptor puede resolver la incertidumbre del mensaje, lo que la convierte en el límite de velocidad de la comunicación.

Por último, demostró que la comunicación fiable de la información de la fuente frente al ruido es posible si y sólo si H < C. Así, la información es como el agua: Si el caudal es inferior a la capacidad de la tubería, la corriente pasa de forma fiable.

Aunque se trata de una teoría de la comunicación, es, al mismo tiempo, una teoría de cómo se produce y transfiere la información: una teoría de la información. Por eso Shannon es considerado hoy «el padre de la teoría de la información».

Sus teoremas condujeron a algunas conclusiones contraintuitivas. Supongamos que usted está hablando en un lugar muy ruidoso. ¿Cuál es la mejor manera de asegurarse de que su mensaje llega? ¿Quizás repetirlo muchas veces? Ése es sin duda el primer instinto de cualquiera en un restaurante ruidoso, pero resulta que no es muy eficaz. Seguro que cuantas más veces te repitas, más fiable será la comunicación. Pero has sacrificado la velocidad por la fiabilidad. Shannon nos mostró que podemos hacerlo mucho mejor. Repetir un mensaje es un ejemplo de utilizar un código para transmitir un mensaje, y utilizando códigos diferentes y más sofisticados, se puede comunicar rápidamente – hasta el límite de velocidad, C – manteniendo cualquier grado de fiabilidad.

Otra conclusión inesperada que se desprende de la teoría de Shannon es que, sea cual sea la naturaleza de la información (un soneto de Shakespeare, una grabación de la Quinta Sinfonía de Beethoven o una película de Kurosawa), siempre es más eficaz codificarla en bits antes de transmitirla. Así, en un sistema de radio, por ejemplo, aunque tanto el sonido inicial como la señal electromagnética enviada por el aire son formas de onda analógicas, los teoremas de Shannon implican que lo óptimo es digitalizar primero la onda sonora en bits, y luego mapear esos bits en la onda electromagnética. Este sorprendente resultado es la piedra angular de la moderna era de la información digital, en la que el bit reina como moneda universal de la información.

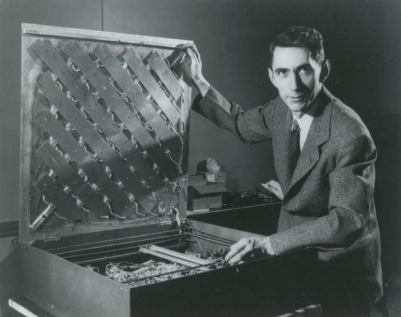

Shannon también tenía un lado lúdico, que a menudo llevaba a su trabajo. Aquí, posa con un laberinto que construyó para un ratón electrónico, llamado Theseus.

La teoría general de la comunicación de Shannon es tan natural que es como si hubiera descubierto las leyes de la comunicación del universo, en lugar de inventarlas. Su teoría es tan fundamental como las leyes físicas de la naturaleza. En ese sentido, era un científico.

Shannon inventó nuevas matemáticas para describir las leyes de la comunicación. Introdujo nuevas ideas, como la tasa de entropía de un modelo probabilístico, que se han aplicado en ramas matemáticas de gran alcance, como la teoría ergódica, el estudio del comportamiento a largo plazo de los sistemas dinámicos. En ese sentido, Shannon era un matemático.

Pero, sobre todo, Shannon era un ingeniero. Su teoría estaba motivada por problemas prácticos de ingeniería. Y aunque era esotérica para los ingenieros de su época, la teoría de Shannon se ha convertido en el marco estándar en el que se basan todos los sistemas de comunicación modernos: ópticos, submarinos e incluso interplanetarios. Personalmente, he tenido la suerte de formar parte de un esfuerzo mundial por aplicar y ampliar la teoría de Shannon a la comunicación inalámbrica, aumentando la velocidad de las comunicaciones en dos órdenes de magnitud a lo largo de múltiples generaciones de estándares. De hecho, el estándar 5G que se está implantando actualmente utiliza no uno, sino dos códigos prácticos probados para alcanzar el límite de velocidad de Shannon.

Aunque Shannon murió en 2001, su legado sigue vivo en la tecnología que conforma nuestro mundo moderno y en los dispositivos que creó, como este autobús teledirigido

Shannon descubrió la base de todo esto hace más de 70 años. ¿Cómo lo hizo? Centrándose implacablemente en la característica esencial de un problema e ignorando todos los demás aspectos. La simplicidad de su modelo de comunicación es una buena ilustración de este estilo. También sabía centrarse en lo que es posible, más que en lo que es inmediatamente práctico.

El trabajo de Shannon ilustra el verdadero papel de la ciencia de alto nivel. Cuando empecé a estudiar en la universidad, mi asesor me dijo que el mejor trabajo era podar el árbol del conocimiento, en lugar de hacerlo crecer. Entonces no sabía qué pensar de este mensaje; siempre pensé que mi trabajo como investigador era añadir mis propias ramitas. Pero a lo largo de mi carrera, cuando tuve la oportunidad de aplicar esta filosofía en mi propio trabajo, empecé a entenderlo.

Cuando Shannon empezó a estudiar la comunicación, los ingenieros ya tenían una gran colección de técnicas. Fue su trabajo de unificación el que podó todas estas ramitas de conocimiento en un único árbol coherente y encantador, que ha dado sus frutos a generaciones de científicos, matemáticos e ingenieros.